2025.07.07 2024.08.05

検索エンジンのロボットの動きやアクセスを制限させるためによく活用されるのが、robots.txtがあります。

検索エンジンがサイトをクロールする際真っ先に見るファイルとなるのがrobots.txtです。書き方を間違えると、ページがクロールされないということもあるため、正しい書き方を覚えておきましょう。

この記事では、robots.txtの書き方や確認方法、SEO上の効果について紹介します。

目次

robots.txtとは

robots.txtとは検索エンジンのクローラーのWebページへのアクセスを制限するためのファイルです。

このファイルの記述によって検索エンジンに認識させる必要のないページ(価値のないページやシステムによって自動的に吐き出されてしまうページ等)を検索エンジンが認識しないようにできます。

ただしこの記述に強制力はないため、制限したとしてもインデックスしてしまう可能性がありますので注意が必要です。

robots.txtのSEO効果

robots.txt自体のSEO効果はそこまで高くありません。

ただし、大規模サイトにおいてはrobots.txtの設定がSEO効果に影響する可能性があります。

1サイトにおいてクロールできるページ数は決まっていると言われているので、ECサイトやメディアサイトなどの大規模サイトでは、すべてのページを見てもらえない可能性があります。

検索エンジンがクロールする必要のないページ、逆に優先的にクロールしてほしいページ、サイトマップXMLのありか等を記載しておくことで、クローラビリティを向上することができます。

robots.txtの書き方

robots.txtの一般的な記述方法は以下です。(Wordpressの場合)

|

|

WordPressにはrobots.txtファイルが最初から設定されています。設定する内容としては以下があります。

- User-agent

- Disallow

- Allow

- Sitemap

それぞれの項目については以下で説明していきます。

User-agent

User-agentはクローラーのユーザーエージェントを指定する記述で、必須項目です。

上記のように「User-agent:*」とするとすべてのクローラーが対象となります。基本的にはこのように記述しておけば問題ありません。

特定のクローラーのみに許可したい場合には、以下を参考に指定しましょう。

|

記述内容 |

意味 |

|

User-agent:* |

すべてのクローラーを許可 |

|

User-agent:Googlebot |

Googleの検索エンジンを許可 |

|

User-agent:Googlebot-image |

Google 画像検索と画像に依存するサービスの画像 URL のクロールを許可 |

|

User-agent:Googlebot-Video |

Google Video と動画に依存するサービスの動画 URL のクロールを許可 |

|

User-agent:Bingbot |

Bingの検索エンジンを許可 |

|

User-agent:Baiduspider |

バイドゥの検索エンジンを許可 |

参考:Google クローラーとフェッチャーの概要(ユーザー エージェント)

Disallow

Disallowは、クロールを拒否したいページやパスを指定します。

記述するページとしては、価値の低いページやシステムによって自動的に吐き出されてしまうページ、会員限定のページ等の検索結果に表示する必要のないページが主です。

Allow

Allowについてはクロール許可の記述です。何もルールを指定しない場合、すべてのページがクロール対象となるため、Allowをあえて使う場合は少ないです。

ただし次に説明するようなケースでは「Allow」を使うことが多いので、覚えておきましょう。

以下のような記述の場合、「/aaa/で始まるパスをクロールしない」が、「/aaa/と正確に一致するページと/aaa/ccc/で始まるパスのクロールを許可する」という指定になります。

|

|

Sitemap.xml

サイトマップの記述に関しては設置しているsitemap.xmlのURLを記述しましょう。sitemap.xmlが複数ある場合はすべて記載しましょう。

必須項目ではないですが、robots.txtは検索エンジンが最初に見に行くファイルとなるため、sitemap.xmlの場所を記載しておくことで、効率よく巡回してくれます。

また、sitemap.xmlに関しては、絶対パスで記述する必要がある点を注意しましょう。

sitemap.xmlの作り方などについては以下の記事で説明しています。

2つの正規表現について

DisallowやAllowの指定においては、以下で紹介する2つの正規表現による記載も可能です。

上記にある例のように、特定ディレクトリの中でも一部ページはクロールを許可したいケースや特定の拡張子のみクロールを拒否したいケース等では正規表現を使って指定しましょう。

ワイルドカード(*)

- 特定のディレクトリのすべてのページのクロールを拒否(「/aaa/を含むページを拒否)

Disallow:/aaa/* - 特定のクエリパラメータを含むURLのクロールを拒否(「?abcd」のパラメータを含むページを拒否)

Disallow:/*?abcd

ドルマーク($)

文字列の終わりを示すために使用されます。

- 「.pdf」でおわるすべてのURLを拒否

Disallow:/*.pdf$

robots.txtの確認方法

以前までは、robots.txtを作成したら、記載内容に誤りがないか、robots.txtテスターで確認することができました。

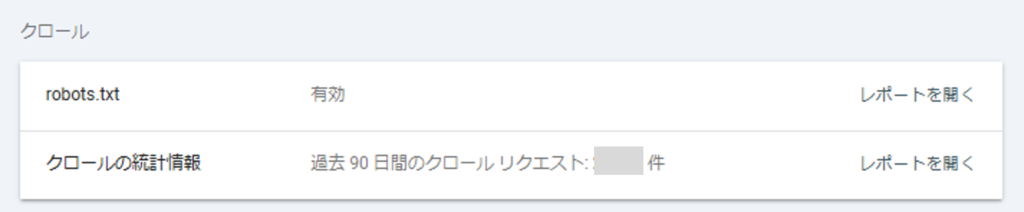

しかしrobots.txtテスターは2023年12月に廃止されたため、現在はGoogle Search Consoleのrobots.txtレポートによりステータスの確認ができます。

設定の中の「クロール」という項目の中に「robots.txt」のレポートへのリンクがあります。

「レポートを開く」を押すとレポート一覧に遷移します。

正常に取得されている場合はキャプチャのように「取得済み」と表示されますが、問題がある場合はエラーが表示されます。

エラーは以下のように表示されます。

- 未取得 – 見つかりませんでした(404)

- 未取得 – その他の理由

それぞれの内容については、Google Search Consoleヘルプの「robots.txtレポート」をご確認ください。

robots.txtの設置方法

robots.txtは、ルートドメインにファイルを設置します。それ以外の場所に設置しても意味をなさないので注意が必要です。

また、ファイル名は「robots.txt」としましょう。

robots.txtにおける注意点

注意点は以下になります。

- robots.txtは絶対的ではない

- ユーザーのアクセス制御はできない

- インデックス除外には使えない

robots.txtは絶対的ではない

robots.txtにおいて指示した内容に関しても必ずその通りになるとは限りません。

クローラーが記述を無視してしまうケースもあります。

Googleは、他のサイトから導線があるページはインデックス登録される可能性があると説明しています。

参考:robots.txtの概要「robots.txt ファイルの制約について」

ユーザーのアクセス制御はできない

クローラーに見る必要のないページを指示することはできますが、ユーザーにアクセスしないでほしいページを記載しても意味を成しません。

ユーザーの閲覧を制御したい場合は、.htaccess等を使ってBasic認証などの設定をしましょう。

インデックス除外には使えない

robots.txtができるのはあくまで、クロール制御です。インデックス制御ができないという点は注意が必要です。

インデックスされているページにクロールをブロックしても、インデックスされた状態のまま、クロールができなくなります。

|

クロール制御 |

インデックス制御 |

|

|

robots.txt |

Allow、Disallowにて制御可能 |

現状維持 |

|

meta robotsタグ |

不可 |

noindexにより制御可能 |

インデックス制御には以下の記事で紹介しているmeta robotsタグを使ってnoindexの指示を送るようにしましょう。

まとめ

この記事ではrobots.txtについてご説明しました。

robots.txtは特に、大規模サイトにおいて重要な役割を果たします。robots.txtをうまく使い、クローラビリティをよくすることで、SEO効果の向上を目指しましょう。

弊社では、SEOコンサルティングサービスを提供しています。今回ご紹介した基本的な内容のほか、コンテンツ改善~CVR改善までお手伝いします。

SEOに関する概要について知りたい方は、以下の記事で詳しく紹介していますので、合わせてご覧ください。

SEOコンサルタントチーム

さまざまな業種業態のサイトのSEO対策の経験を経たSEOコンサルタントがSEO対策におけるお役立ち情報を発信します。 ”SEO”の生みの親であるブルースクレイからローカライズした内部施策をはじめとするSEOのノウハウをわかりやすくお届けします。

BCJメールマガジンのご登録

最新のセミナー情報やお役立ち情報をメールにてお届け致します!

-

Google Broke Its Own Hreflang Rule, Revealed By SEOdin Page Analyzer

2026.02.25

View more

-

SEOコンサル・広告代理店の仕事内容は「施策」だけじゃない──成果を左右する、表に出ない仕事の話

2026.02.10

View more

-

【サイト改善事例】カテゴリ修正とタグ追加で、既存コラムの検索順位が改善した理由

2026.02.10

View more

-

Googleが自らのルールを破る時:Google for Developersの「SEOやらかし」を暴く!

2026.02.03

View more

-

【2026年最新版】LLMO対策会社10選を徹底比較!費用やSEOとの違い・選び方も解説

2026.01.14

View more

-

【2026年のSEO展望】GEO・SOV時代の最適戦略とは?AI時代に勝ち続けるための全戦略とKPIシフト

2025.12.03

View more